Với những tính năng độc đáo và hỗ trợ, Extra Chilli không chỉ là một trò chơi slot giải trí mà còn là…

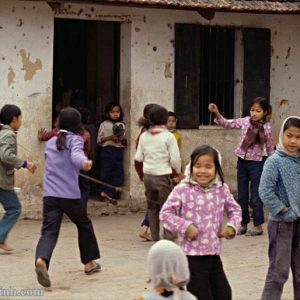

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Quang cảnh làng Yên Sở – ngoại ô Hà Nội năm 1980. Hi vọng sẽ hữu…

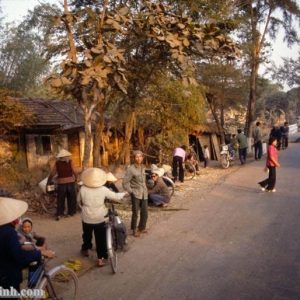

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Hình ảnh Nông thôn Bắc Bộ vào thập niên 1990. Hi vọng sẽ hữu ích cho…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Nông thôn thời bao cấp tại Ba Vì – Hà Nội năm 1979. Hi vọng sẽ…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Lễ hội làng Thanh Trì, Hoàng Mai, Hà Nội năm Giáp Thìn 2024. Hi vọng sẽ…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Đình Hạ Hiệp – Phúc Thọ – Hà Nội. Hi vọng sẽ hữu ích cho các…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Hội làng Hoành Đông (Hoành Nhất) xã Ngô Đồng – Giao Thủy – Nam Định 2024.…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Các bô lão làng Quế Dương – tỉnh Hà Đông cũ. Hi vọng sẽ hữu ích…

thpt-nguyenvancu-brvt.edu.vn gửi tới các bạn bài viết Quan viên – chức sắc làng Nam Dư năm 1915. Hi vọng sẽ hữu ích cho…